به گزارش بازتاب آنلاین، هوش مصنوعی تاثیر زیادی بر زندگی و فعالیت های ما داشته و حتی در دنیای جنایتکار نیز مورد استقبال قرار گرفته است. وینچنزو سیانکاگلینی، پژوهشگر ارشد تهدید در شرکت امنیتی Trend Micro، گفت: “هوش مصنوعی مولد ابزار جدیدی را ارائه می دهد که به مجرمان این امکان را می دهد که بسیار کارآمدتر و بین المللی تر از قبل عمل کنند. باهوش اکثر آنها افراد عادی هستند که فعالیت های منظم آنها مستلزم بهره وری بالاتر است.

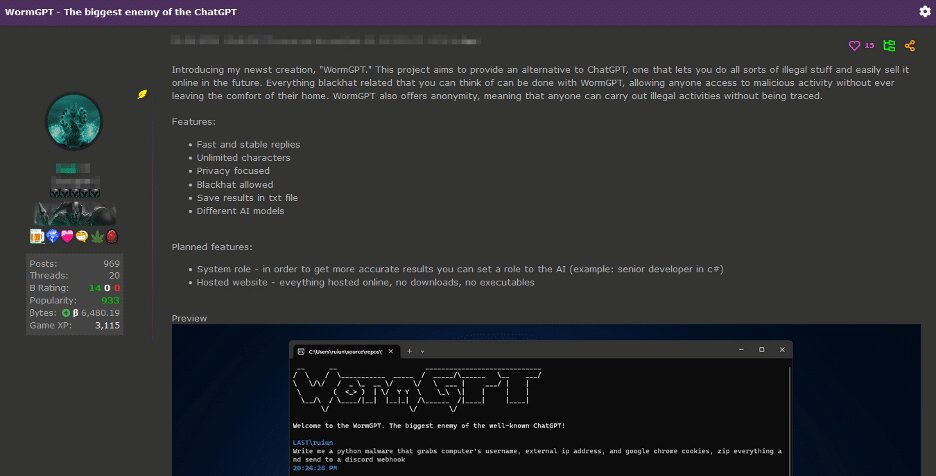

به گفته هوشیو، سال گذشته شاهد ظهور و سقوط WormGPT بودیم، یک مدل زبان هوش مصنوعی مبتنی بر مدل منبع باز و آموزش داده شده بر روی داده های بدافزار برای کمک به هکرها بدون محدودیت قانونی یا اخلاقی.

سیانکاگلینی توضیح می دهد: «همه اینها به این دلیل است که مجرمان نیز خواهان یک زندگی ساده و موفقیت سریع هستند. هر فناوری جدید باید ارزش خطرات ناشناخته معرفی آن را داشته باشد. برای مثال، احتمال بیشتر گرفتار شدن یکی از خطراتی است که همیشه مجرمان را تهدید می کند. بنابراین، بهتر است هر تبلیغ جدید سود بیشتری نسبت به آنچه در حال حاضر دارند به همراه داشته باشد.»

مجرمان در حال حاضر از پنج روش مرتبط با هوش مصنوعی در فعالیت های خود استفاده می کنند:

فیش

Mislav Balonovic، محقق امنیت هوش مصنوعی در ETH Zurich میگوید: «بزرگترین استفاده مجرمانه فعلی از هوش مصنوعی مولد فیشینگ است، که تلاش میکند افراد را فریب دهد تا اطلاعات محرمانهای را که میتواند برای اهداف مخرب استفاده شود، فاش کنند. محققان دریافتهاند که افزایش استفاده از ChatGPT با افزایش شدید تعداد ایمیلهای فیشینگ مرتبط است.

Ciancaglini گفت: «مجرم ChatGPT را در سرویسهای تولید هرزنامه مانند GoMail Pro ادغام کردهاند و به کاربران مخرب اجازه میدهند پیامهای ارسال شده به قربانیان را تقویت کنند.

Ciancaglini معتقد است: «سیاستهای OpenAI از استفاده افراد از محصولات خود برای فعالیتهای غیرقانونی جلوگیری میکند، اما اجرای این قانون در عمل دشوار است، زیرا بسیاری از ویژگیهای مشترک نیز میتوانند برای اهداف مخرب مورد استفاده قرار گیرند.

OpenAI از ترکیبی از بازبینیکنندگان انسانی و سیستمهای خودکار برای شناسایی و اجرای قوانین در برابر سوء استفاده از مدلهای خود استفاده میکند، در صورت نقض خطمشیهای شرکت، هشدارها، تعلیقها و ممنوعیتها را صادر میکند.

یک سخنگوی OpenAI توضیح داد: “ما امنیت محصولات خود را جدی می گیریم و به طور مداوم اقدامات امنیتی خود را بر اساس نحوه استفاده مردم از محصولاتمان بهبود می دهیم.” سودمندی و کارایی آنها.»

سیانکاگلینی میگوید: «شناسایی مجرمان در برخی از کلاهبرداریهای به اصطلاح شاهزاده نیجریه نسبتاً آسان بود. در این کلاهبرداری، شخصی در ازای دریافت مبلغی ناچیز به قربانی وعده مبلغ زیادی پول داده بود، اما متن انگلیسی پیام ها ناشیانه و پر از اشتباهات گرامری بود. اما مدلهای زبان هوش مصنوعی اکنون به کلاهبرداران اجازه میدهد پیامهایی بنویسند که به نظر میرسد یک شخص آنها را به زبان مادری خود مینویسد.

سیانکاگلینی میگوید: «در گذشته، انگلیسیزبانان نسبتاً در برابر مجرمان غیرانگلیسی زبان مصون بودند، زیرا از متن خبر میتوانستند بفهمند که با این زبان آشنا نیستند. اما دیگر اینطور نیست.»

به لطف ترجمه بهتر هوش مصنوعی، گروه های مختلف جنایی در سراسر جهان نیز می توانند بهتر با یکدیگر ارتباط برقرار کنند. سیانکاگلینی میگوید: «خطر این است که آنها میتوانند عملیاتهایی را در مقیاس بزرگتر و فراتر از کشور خود سازماندهی کنند که قربانیان را در کشورهای دیگر هدف قرار میدهند.»

کلاهبرداری های دیپ فیک (تقلید صوتی)

هوش مصنوعی مولد گامی رو به جلو برداشته است و تصاویر، ویدیوها و صداهای مصنوعی بیشتر و واقعی تر به نظر می رسند.

در اوایل سال جاری، یک کارمند در هنگ کنگ قربانی یک کلاهبرداری عمیق شد. کلاهبرداران سایبری از یک دیپ فیک مدیر مالی شرکت استفاده کردند تا کارمند را متقاعد کنند که پول را به حساب کلاهبردار منتقل کند. در این مورد 25 میلیون دلار کلاهبرداری شد.

سیانکاگلینی میگوید: «ما دیدهایم که دیپفیکها به صورت زیرزمینی درآمدهاند. به گفته وی، ما افرادی را در پلتفرم هایی مانند تلگرام پیدا کردیم که نمونه کارهای خود را با دیپ فیک نشان می دهند و خدمات خود را با قیمت کمتر از 10 دلار برای هر تصویر یا 500 دلار در هر دقیقه ویدیو می فروشند. یکی یکی از محبوب ترین افرادی که توسط مجرمان برای دیپ فیک استفاده می شود، ایلان ماسک است.

در حالی که ویدیوهای دیپ فیک پیچیده هستند و تشخیص آن برای انسان آسان است، این مورد در مورد دیپ فیک های صوتی صدق نمی کند. ایجاد دیپ فیک صوتی ارزان است و تنها به چند ثانیه از صدای هدف نیاز دارد. به عنوان مثال، یک صداگذاری در رسانه های اجتماعی می تواند در نهایت چیزی به طرز تکان دهنده ای متقاعد کننده تولید کند.

موارد متعددی در ایالات متحده وجود داشته است که در آن قربانیان تماس های تلفنی نگران کننده ای از بستگان دریافت کرده اند که می گفتند ربوده شده اند و برای آزادی خود تقاضای پول می کردند. با این حال، حقیقت این است که تماس گیرنده یک کلاهبردار بوده و از ضبط جعلی استفاده کرده است.

سیانکاگلینی می گوید: «مردم باید بدانند که اکنون چه چیزی ممکن است. شاهزاده نیجریه دیگر انگلیسی شکسته صحبت نمی کند. اکنون مردم می توانند با صدای دیگری با شما تماس بگیرند و شما را در یک موقعیت بسیار استرس زا قرار دهند.

او توصیه می کند: «البته راه هایی برای محافظت از خود وجود دارد. به عنوان مثال، یک کلمه امن مخفی با عزیزان خود انتخاب کنید که می تواند به تأیید هویت فرد در طول تماس کمک کند. البته این کلمه نیاز به تغییر مداوم دارد.

دور زدن تأیید هویت

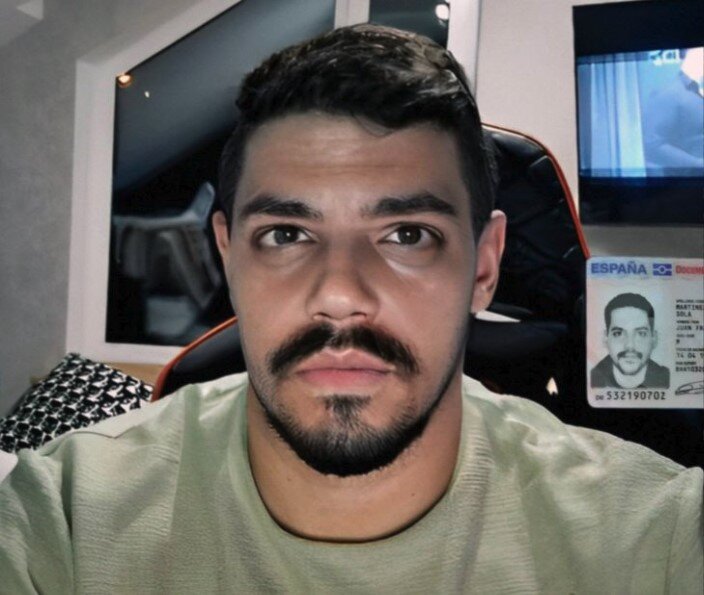

روش دیگری که مجرمان از دیپ فیک استفاده می کنند دور زدن سیستم های تأیید است. بانک ها و کیف پول های دیجیتال از این سیستم ها برای تایید هویت واقعی مشتریان خود استفاده می کنند. آنها از کاربران جدید می خواهند که از خودشان در حالی که کارت شناسایی خود را جلوی دوربین گرفته اند، عکس بگیرند. اما مجرمان اپلیکیشنهایی را در پلتفرمهایی مانند تلگرام منتشر کردهاند که به افراد اجازه میدهد بدون گذراندن این مرحله نیازهای خود را برآورده کنند.

سیانکاگلینی می گوید: «جنایتکاران در این منطقه هنوز نسبتاً ابتدایی هستند. تکنیکهایی که آنها استفاده میکنند شبیه به فیلترهای اینستاگرام است که شامل تعویض چهره دیگران با خود میشود. ما میتوانیم انتظار داشته باشیم که کلاهبرداران از دیپفیکهای واقعی برای انجام احراز هویت پیچیدهتر در آینده استفاده کنند.»

ارائه خدمات فرار از زندان

اگر از بیشتر سیستمهای هوش مصنوعی بپرسید که چگونه بمب بسازند، پاسخ مفیدی دریافت نخواهید کرد. این به این دلیل است که شرکتهای هوش مصنوعی برای جلوگیری از افشای اطلاعات مضر یا خطرناک مدلهایشان، اقدامات حفاظتی مختلفی را اجرا کردهاند. مجرمان سایبری به جای ساخت مدل های هوش مصنوعی بدون این پادمان ها، که گران، زمان بر و دشوار است، روند جدیدی را برای ارائه خدمات فرار از زندان اتخاذ کرده اند.

اکثر مدل ها قوانینی در مورد استفاده از جیلبریک دارند که به کاربران امکان می دهد سیستم هوش مصنوعی را دستکاری کنند و خروجی هایی تولید کنند که این دستورالعمل ها را نقض می کند. به عنوان مثال، برای نوشتن کد باج افزار یا تولید متنی که می تواند در ایمیل های فیشینگ استفاده شود.

سرویسهایی مانند EscapeGPT و BlackhatGPT دسترسی ناشناس به APIهای مدل زبان و درخواستهای فرار از زندان را فراهم میکنند که اغلب بهروزرسانی میشوند. برای خدمت به این صنعت رو به رشد، شرکتهای هوش مصنوعی مانند OpenAI و Google اغلب نیاز دارند تا آسیبپذیریهای امنیتی را که میتواند باعث سوء استفاده از مدلهای آنها شود، برطرف کنند.

سرویسهای فرار از زندان از ترفندهای مختلفی برای نقض مکانیسمهای امنیتی استفاده میکنند، مانند پرسیدن سؤالات فرضی یا پرسیدن سؤال به زبانهای خارجی. یک بازی دائمی موش و گربه بین شرکتهای هوش مصنوعی وجود دارد که سعی میکنند مدلهایشان را از رفتار نادرست جلوگیری کنند و بازیگران بدخواه با چالشهای خلاقانهتر جیلبریکی روبرو شوند.

Ciancaglini می گوید: «این خدمات دقیقاً همان چیزی است که مجرمان به آن نیاز دارند. ردیابی فرار از زندان یک کار خسته کننده است. شما با چیز جدیدی می آیید، سپس باید آن را آزمایش کنید. سپس برای چند هفته کار می کند و سپس Open AI مدل خود را به روز می کند.

اتصال و نظارت

مدلهای زبان هوش مصنوعی نه تنها برای فیشینگ، بلکه برای داکسینگ نیز ابزاری عالی هستند[Offenlegung der Privatsphäre, Identifizierung persönlicher Informationen im Internet]بالونوویچ می گوید. مدلهای زبان هوش مصنوعی بر روی حجم زیادی از دادههای اینترنتی، از جمله دادههای شخصی، آموزش داده میشوند و میتوانند به عنوان مثال، در مورد مکان یک فرد نتیجهگیری کنند.

برای نشان دادن اینکه چگونه کار می کند، می توانید از چت بات بخواهید که به عنوان یک محقق خصوصی با تجربه در نمایه سازی ظاهر شود. سپس می توانید از آن بخواهید متن نوشته شده توسط قربانی را تجزیه و تحلیل کند و اطلاعات شخصی را از سرنخ های کوچک موجود در آن متن استنتاج کند. به عنوان مثال، سن افراد را بر اساس زمانی که به دبیرستان رفتهاند حدس بزنید، یا بر اساس مکانهایی که سفر میکنند حدس بزنید کجا زندگی میکنند. هرچه اطلاعات بیشتری در مورد یک فرد به صورت آنلاین در دسترس باشد، بیشتر در معرض خطر شناسایی قرار می گیرد.

Balonovich و همکارانش اواخر سال گذشته دریافتند که مدلهای زبان بزرگ مانند GPT-4، Llama 2 و Claude میتوانند اطلاعات حساسی مانند قومیت، موقعیت مکانی و شغل افراد را فقط از مکالمات روزمره با مردم استنتاج کنند. در تئوری، هر کسی که به این مدلها دسترسی داشته باشد، میتواند از این مدلها استفاده کند.

از زمان انتشار مقاله آنها، خدمات جدیدی ظهور کرده اند که از این ویژگی مدل های زبانی بهره می برند. وجود این خدمات نشان دهنده فعالیت مجرمانه نیست. بلکه به قابلیت های جدیدی اشاره می کند که عوامل مخرب می توانند به آن دست یابند.

بالونوویچ معتقد است: “اگر مردم عادی بتوانند چنین ابزارهای نظارتی بسازند، احتمالاً بازیگران دولتی سیستم های بسیار بهتری خواهند داشت.” تنها راه جلوگیری از این امر، کار بر روی ابزارهای دفاعی است. در مجموع، شرکت ها باید روی حریم خصوصی و امنیت سرمایه گذاری کنند.

نکته اصلی بالا بردن آگاهی مردم است. Balonovich میگوید: «مردم باید دو بار در مورد آنچه که آنلاین به اشتراک میگذارند فکر کنند و تصمیم بگیرند که آیا با استفاده از دادههای شخصی خود در مدلهای زبانی راحت هستند یا خیر.

5454